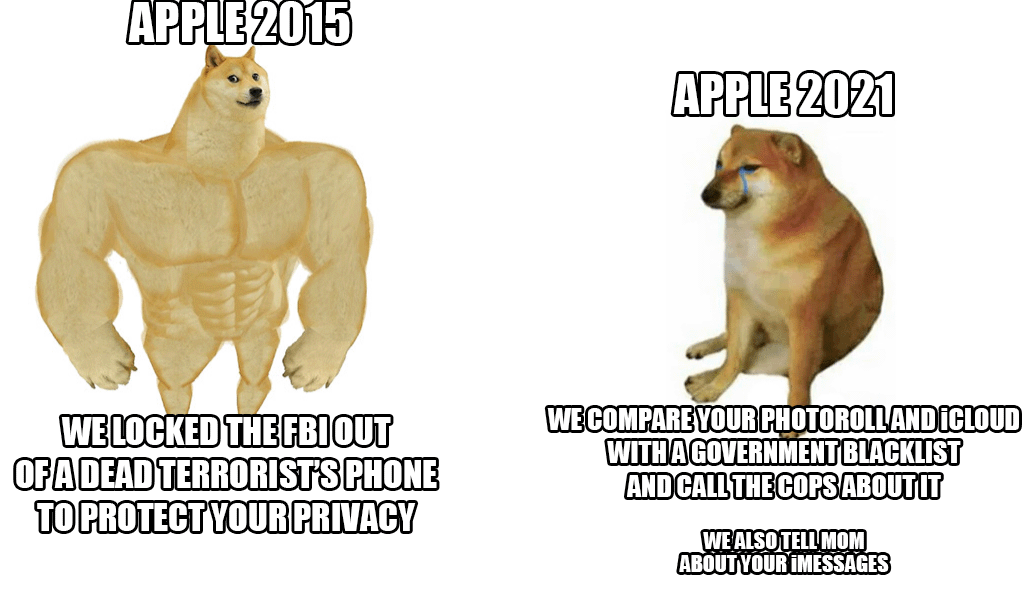

В конце прошлой недели Apple представила новую систему по борьбе с жестоким обращением с детьми, которая будет сканировать практически все фотографии iCloud. Хотя на первый взгляд идея звучит неплохо, ведь детей действительно нужно защищать от этой акции, купертинский гигант тем не менее подвергся лавинной критике – не только со стороны пользователей и экспертов по безопасности, но и в рядах самих сотрудников.

По последней информации уважаемого агентства Reuters ряд сотрудников выразили обеспокоенность по поводу этой системы во внутреннем сообщении Slack. Якобы им следует опасаться возможных злоупотреблений со стороны властей и правительств, которые могут злоупотребить этими возможностями, например, подвергнуть цензуре людей или отдельные группы. Раскрытие системы вызвало бурную дискуссию, в рамках которой уже имеется более 800 отдельных сообщений в вышеупомянутом Slack. Короче говоря, сотрудники обеспокоены. Даже эксперты по безопасности ранее обращали внимание на то, что в чужих руках это будет действительно опасное оружие, используемое для подавления активистов, их упомянутой цензуры и тому подобного.

Хорошей новостью (пока) является то, что новинка появится только в США. На данный момент даже неясно, будет ли система использоваться и внутри государств Евросоюза. Однако, несмотря на всю критику, Apple стоит на своем и защищает систему. Прежде всего он утверждает, что вся проверка происходит внутри устройства и, как только обнаруживается совпадение, только в этот момент дело снова проверяется сотрудником Apple. Только по его усмотрению оно будет передано в соответствующие органы.

Возможно вас интересует

Мне не хотелось бы переходить с iCloud на что-то безопасное и по-настоящему конфиденциальное, но если Apple будет настаивать, я все равно перестану им платить.

Он будет активен (пока) только в США.

На самом деле не имеет значения, где это будет применяться законодательно. Эта технология уже будет доступна и развернута. Это самый большой риск.